IA partout, vérité nulle part ?

L'intelligence artificielle a le vent en poupe. Il ne se passe pas une journée sans que la presse, spécialisée ou non, parle des prouesses technologiques de l'IA et notamment l'agent conversationnel Chat-GPT en tête. Récemment, on a vu circuler sur les réseaux sociaux une photo du Pape François dans une doudoune peu conventionnelle pour un pape.

On constate effectivement que l'outil est puissant et capable de générer des images très réalistes. Dès lors, comment peut-on identifier des fausses images pour éviter de tomber dans le piège des fake news et de prendre le risque de partager soi-même des infox ?

Changement de paradigme

Jusqu'à présent la lutte contre les fake news consistait à recouper des informations et déployer des méthodes d'investigation numérique pour démontrer qu'un contenu est faux. Désormais, la puissance des outils de génération d'images ou de deepkfake et le degré de réalisme du rendu nous invitent à plus de prudence et nous contraignent à utiliser des outils et des méthodes pour prouver que le contenu est authentique.

Tout d'abord, le premier réflexe est d'identifier le contexte de la diffusion d'une image. Si c'est en lien avec l'actualité, une des intentions de l'auteur-e d'une fausse image peut être de faire de l'humour ou mettre en dérision quelqu'un. La lecture du post ou du message partagé sur les réseaux sociaux peut en effet suffire à comprendre qu'il s'agit d'un trait d'humour.

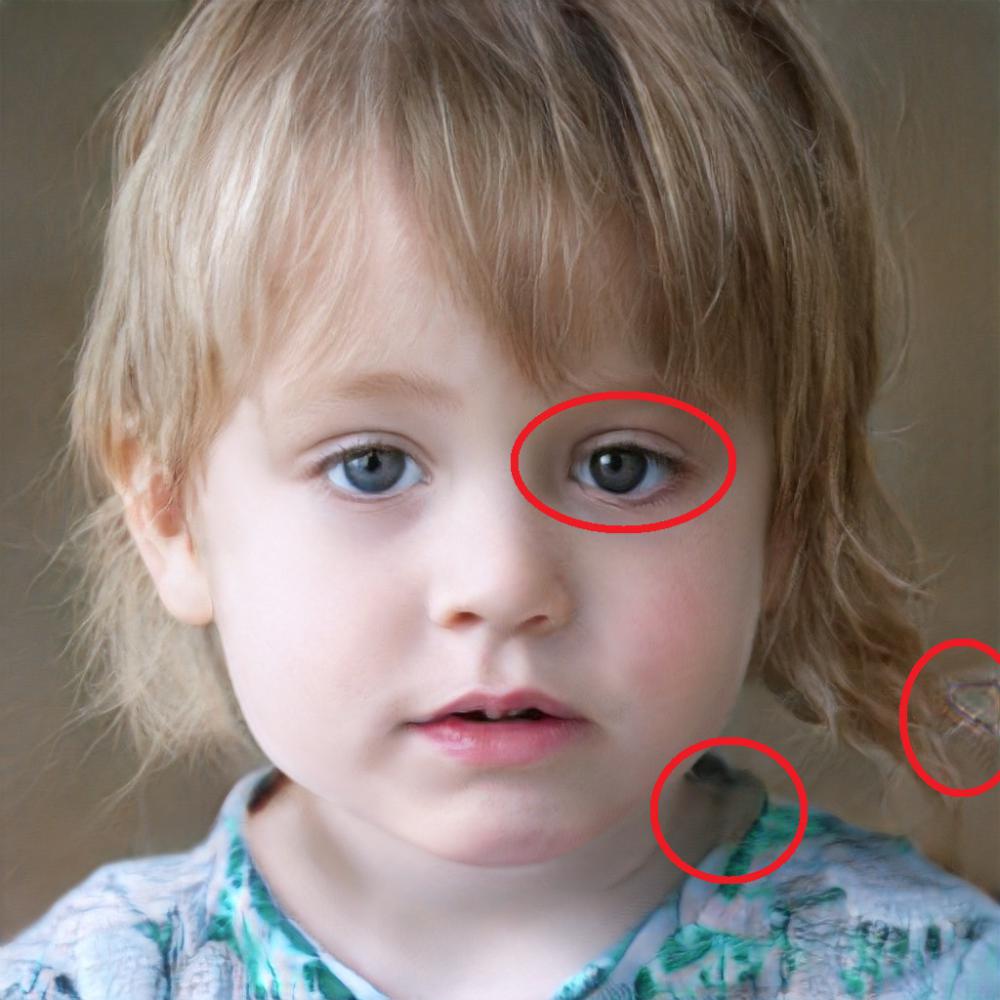

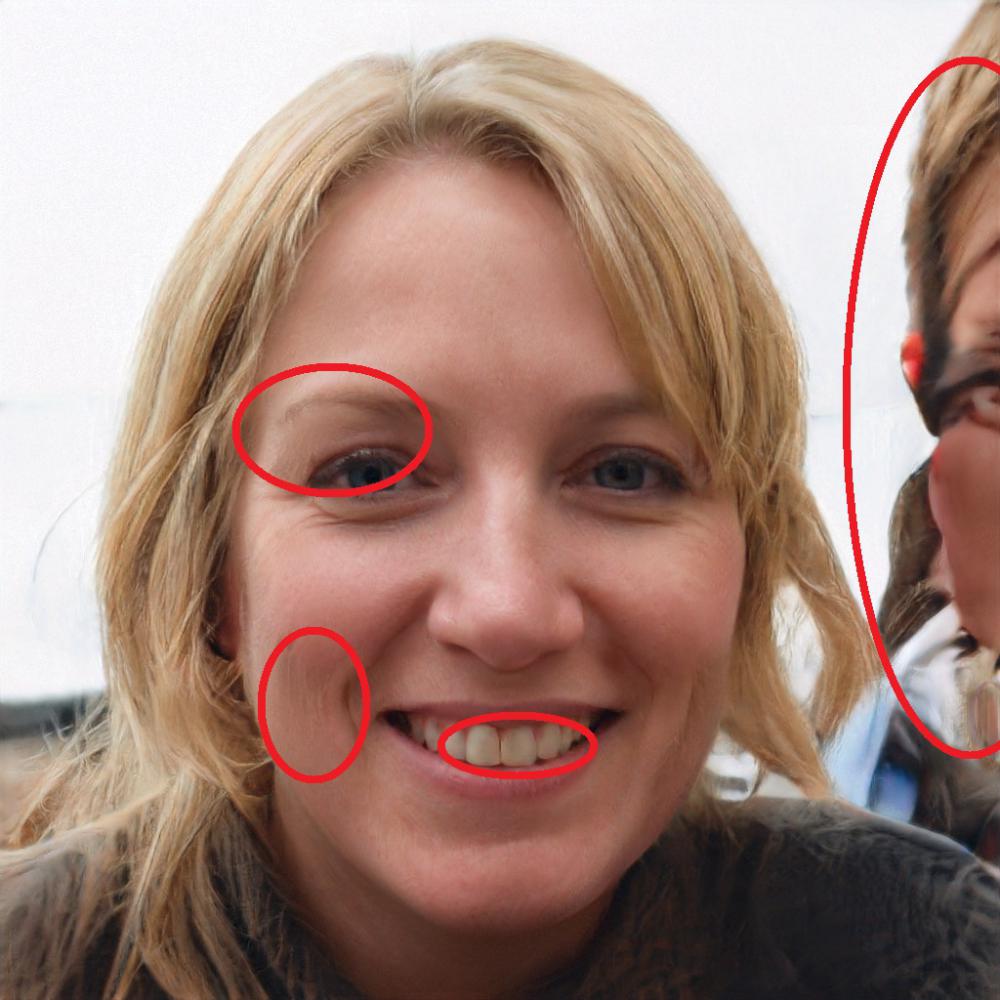

En l'absence de ce genre d'éléments, le second conseil consiste à essayer de décortiquer l'image et d'aiguiser son regard. En effet, si les outils de génération de contenus sont de plus en puissants, les résultats ne sont pas toujours parfaits. Certains éléments d'une image peuvent trahir comme les doigts, les oreilles ou une partie du visage. Les IA ont de grandes difficultés à générer des mains et il est fréquent de voir 6 doigts, des zones de floues ou des parties disproportionnées. L'AFP a effectué un test avec une image de Brad Pitt. Par ailleurs, les outils en ligne comme Dall-E affichent volontairement un symbole ou un logo dans un des angles de l'image pour indiquer que le visuel a été créé par un des services d'IA.

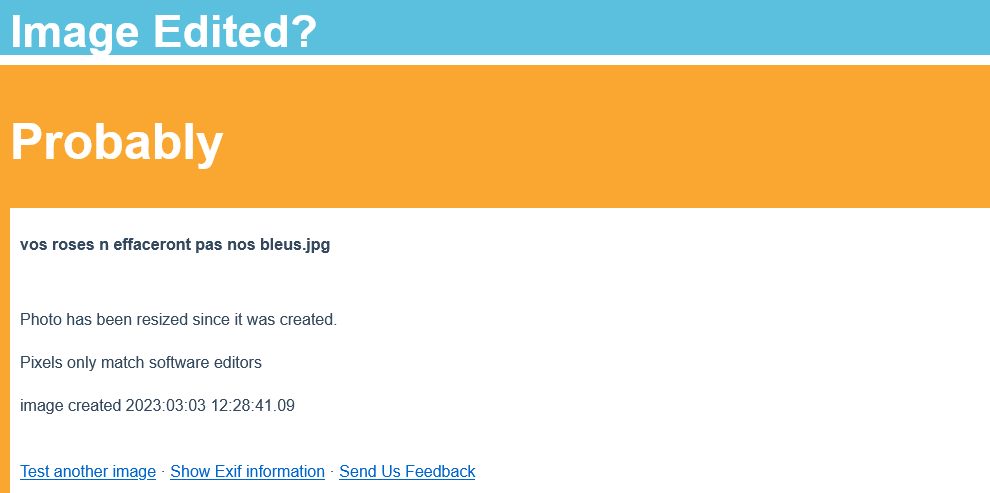

Certes, il suffit de rogner un peu l'image pour faire disparaître ce marqueur. Dans ce cas, il peut être intéressant d'utiliser un moteur de recherche d'images inversé comme TinEye ou même Google Images pour vérifier si la photo apparaît ailleurs en ligne et retrouver ainsi le fichier d'origine qui comporte encore le marqueur visuel. Certains internautes s'amusent effectivement à redimensionner des images pour faire dire autre chose aux images qu'ils diffusent. Grâce à l'outil Image Edited, on peut savoir si l'image a été redimensionnée.

On peut aussi obtenir des informations relatives à l'image. Si elles n'ont pas été effacées, les métadonnées peuvent être affichées et indiquer notamment la date de la prise de vue voire les coordonnées GPS. (Il faut noter que les réseaux sociaux effacent généralement automatiquement ces données). Ce travail de "débunkage" de fake news peut également être complété avec l'outil AI Image Detector. Ce site indique si la photo a été réalisée par un humain ou une IA. Si les résultats ne sont pas fiables à 100%, il permet d'accréditer l'hypothèse que l'image a bien été réalisée par une IA.

Pour apprendre à aiguiser votre regard, nous vous conseillons de vous entraîner avec le site https://www.whichfaceisreal.com/ qui présente deux portraits, un vrai et un créé par une IA. Vous devez cliquer sur le vrai visage. En regardant attentivement, vous découvrirez un détail qui trahit la photo : les yeux, les dents, les cheveux, l'absence de reflet sont des éléments qui prouvent que l'image a été générée par une IA.

Si malgré ces outils, vous avez toujours un doute sur l'authenticité d'une photo, vous pouvez la passer au crible avec l'outil en ligne Forensically. Ce service permet de voir les modifications qui ont été apportées à une photo en faisant apparaître les traces des différentes compressions dans une image. Exemple avec l'image ci-dessous :

En glissant le curseur de gauche à droite ou de droite à gauche, vous verrez deux images. Peu de choses semblent les différencier et il faut regarder attentivement pour les repérer. Mais ce qui peut échapper à l’œil nu peut être identifié via Forensically qui met en évidence les compression des pixels sur l'image.

En conclusion, la chasse aux fausses images est une activité devenue complexe et parfois chronophage. Si nous avons encore quelques outils et moyens de réussir à identifier une image créée par une IA, les méthodes ne garantissent pas un taux de réussite à 100%. Dès lors, la prudence est de mise et le meilleur réflexe est de résister à la tentation de partager sur les réseaux sociaux. De plus, il existe des services qui reposent sur des professionnels aguerris qui mettent en oeuvre leur expertise pour tenter d'identifier des fake news. En cas de doute, n’hésitez pas à solliciter AFP Factuel, les Décodeurs, Checknews, les Observateurs de France 24, vrai ou fake de France Info, Google Fact checking..